Stable Diffusion是一个人工智能图像生成工具,属于非常强大的生成式ai,可以通过文生图或者是图生图的方式进行自由的绘画创作,而且效果比普通的画师要好很多,如果你的电脑配置稍微好一点的话,可以做到1分钟出图,当然前提是需要训练好模型,接下来小编会为大家介绍小白的使用教程,感兴趣的亲们赶紧来看看吧。

stable diffusion2.0手机版app:点击下载

Stable Diffusion怎么使用

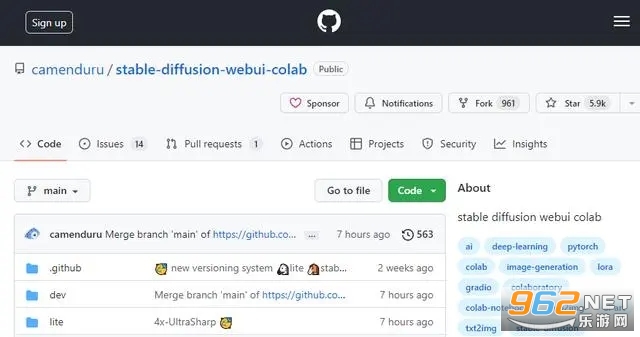

首先打开

https://github.com/camenduru/stable-diffusion-webui-colab网站

这是运行在谷歌colab的,没有显卡也可以生成图片,非常的奈斯

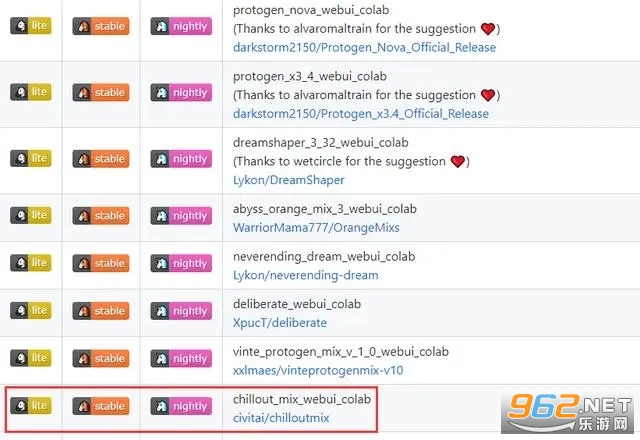

下拉选择一个模型

选择chilloutmix这个模型点击stable运行它,其他的模型都可以试试

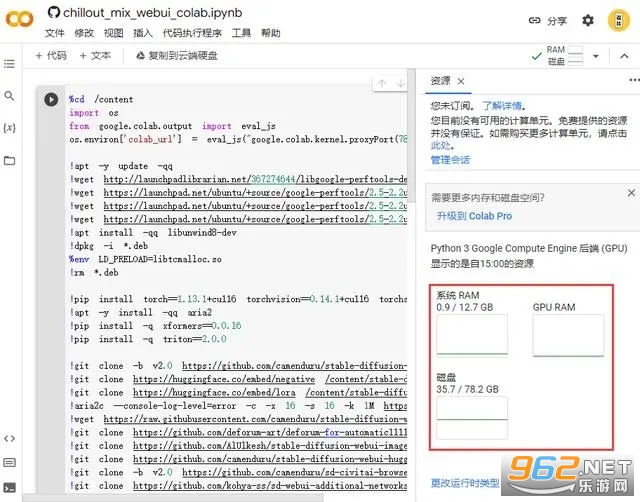

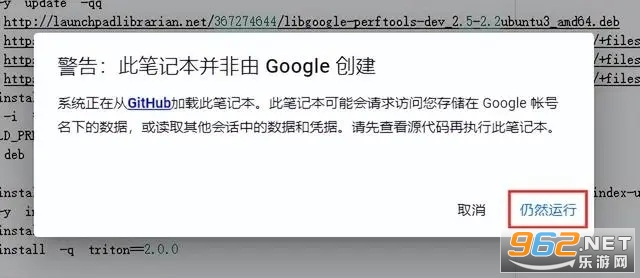

点击连接等待一会

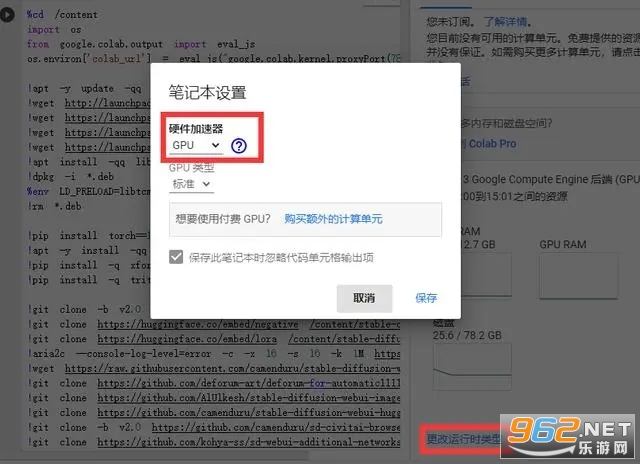

连接成功了里面要有GPU的,没有的话点击更改运行时类型,选择GPU保存

然后点击这个按钮,开始运行

然后点击这个按钮,开始运行

看到出现链接地址就OK了,点击下面的链接进入

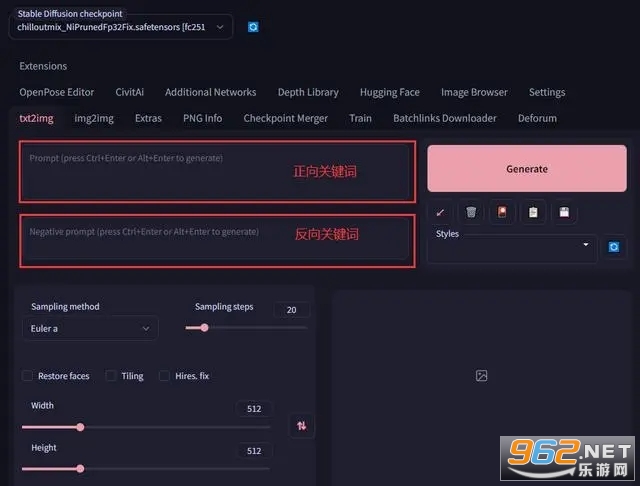

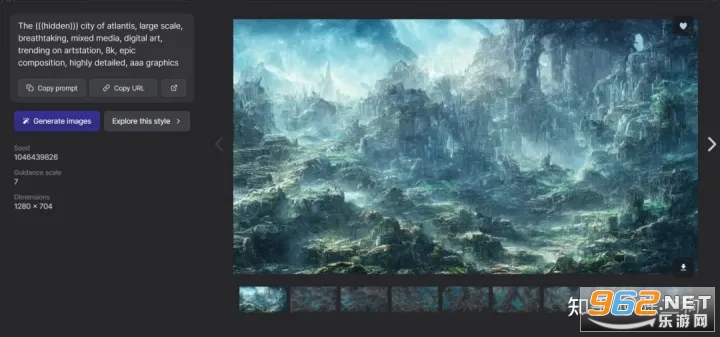

进来的界面就是这样子的,里面两个框框是输入关键词的,正向关键词就是需要AI算出来的画面包含的元素,反向关键词就是不希望出现的怪东西(你懂得),填入好信息后点击Generate等待一会图片就生成出来了。

StableDiffusion怎么喂图

1.文生图

在开始使用文生图之前,有必要了解以下几个参数的含义:

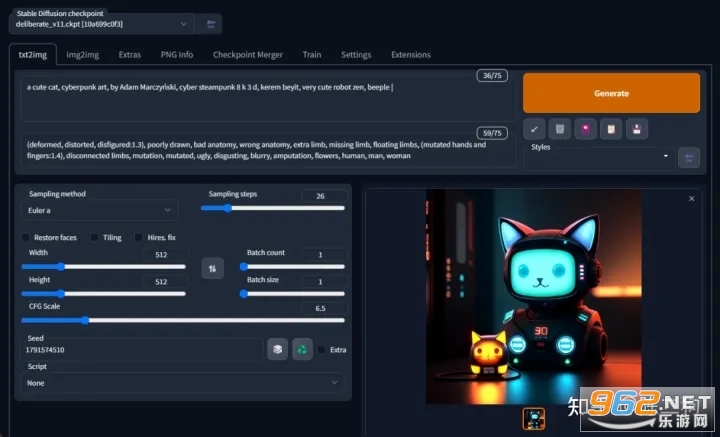

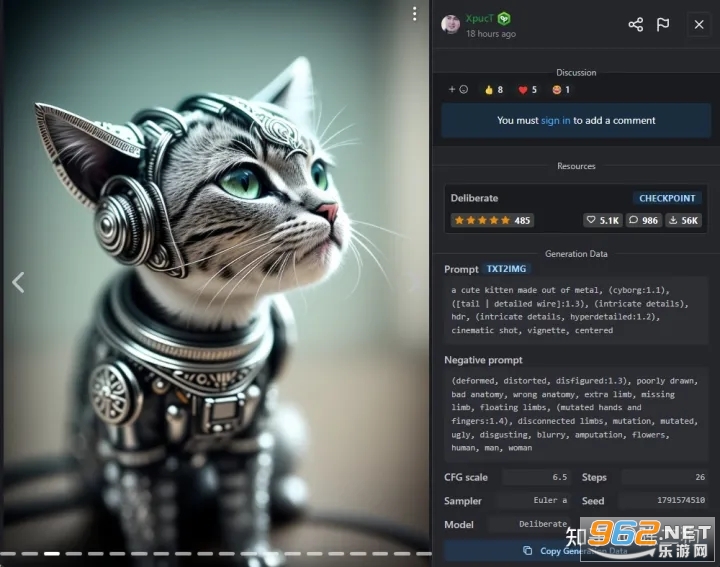

接下来我们来生成一张赛博朋克风格的猫咪图片,配置以下参数后,点击 "Generate" 即可:

Prompt:a cute cat, cyberpunk art, by Adam Marczyński, cyber steampunk 8 k 3 d, kerem beyit, very cute robot zen, beeple |Negative prompt:(deformed, distorted, disfigured:1.3), poorly drawn, bad anatomy, wrong anatomy, extra limb, missing limb, floating limbs, (mutated hands and fingers:1.4), disconnected limbs, mutation, mutated, ugly, disgusting, blurry, amputation, flowers, human, man, womanCFG scale:6.5Sampling method:Euler aSampling steps:26Seed:1791574510

注:提示词(Prompt)越多,AI 绘图结果会更加精准,另外,目前中文提示词的效果不好,还得使用英文提示词。

下载安装后输入自定义prompt,也就是任意你想生成的图像内容,然后点击生成就好了。如果不满意,可以再次点击,每次将随机生成不同的图片,总有一些你感兴趣的。

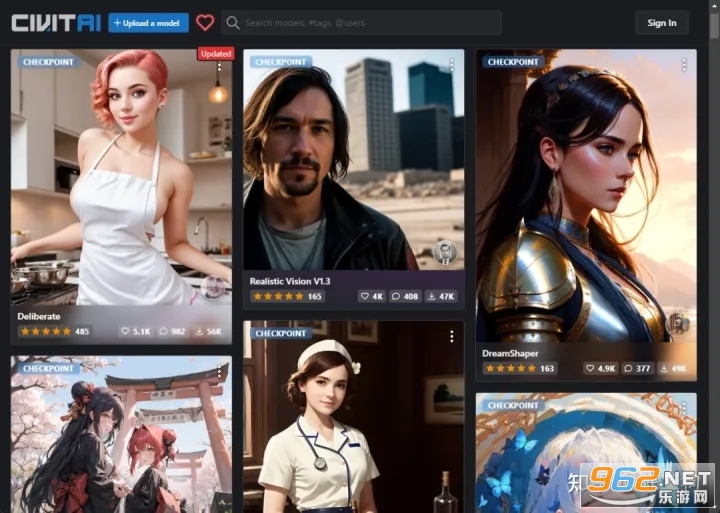

3.图生图

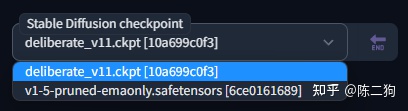

眼尖的你可能发现了,上面截图里左上角 Stable Diffusion checkpoint 的值怎么跟之前截图里的不一样?这是因为我换了一个模型文件,还记得前面提到那个将近 4 个 G 大小的模型文件(v1-5-pruned-emaonly.safetensors)吗?那是 stable-diffusion-webui 的默认模型文件,用这个模型文件生成出来的图片比较丑,因此我换了另一个模型文件。模型文件下载的网站几个,比较出名的就是 civitai,这上面共享的都是别人训练好的模型。

模型文件下载地址:

civitai:https://civitai.com/

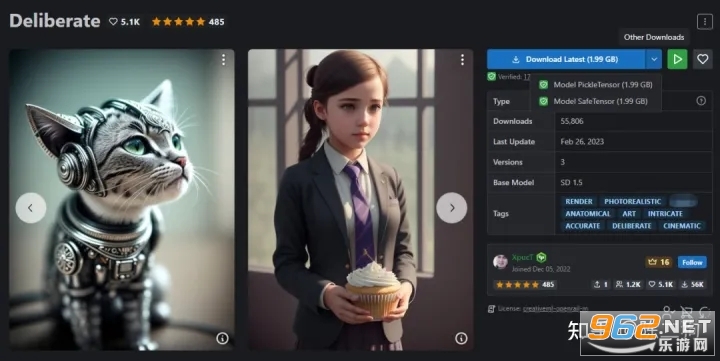

根据你要生成的图片风格(比如:动漫、风景),挑选合适的模型查看,前面那个文生图的例子,使用的就是这个 Deliberate 模型,直接点击 "Download Latest" 即可下载该模型文件。

注:模型文件有 2 种格式,分别是 .ckpt(Model PickleTensor) 和 .safetensors(Model SafeTensor),据说 .safetensors 更安全,这两种格式 stable-diffusion-webui 都支持,随意下载一种即可。

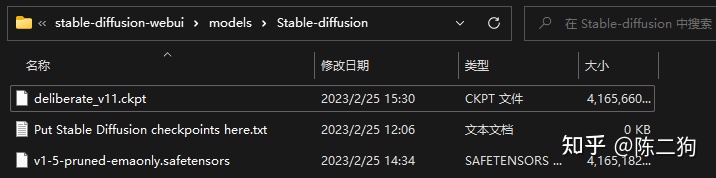

将下载好的模型文件放到 stable-diffusion-webui\models\Stable-diffusion 目录下:

放置好模型文件之后,需要重启一下 stable-diffusion-webui(执行 webui-user.bat)才能识别到。

这些模型文件一般会附带一组效果图,点击任意一张,就可以看到生成该效果图的一些参数配置:

把这些参数配置到 stable-diffusion-webui 中,点击 "Generate" 就可以生成类似效果的图片了。

注:因为 AI 绘图带有随机性质,所以生成出来的图片跟效果图不一定完全一样。

文生图功能有很多东西可以发掘,你可以用它来生成世界上独一无二的图片,而要用好文生图功能,提示词(Prompt)是必须掌握的重中之重,它是有语法规则的,具体接着往下看。

3.TAG生成器

https://tag.muhou.net

关于如何构思prompt提示语,可以从如下几个问题入手:

你想要一张照片,还是一幅画(photo/painting)

你想要什么内容,比如:人物,动物,还是风景(person/animal/landscape)

需要什么样的细节,比如:

环境,室内/室外/水下/太空(indoor/outdoor/underwater/in space)

视角,正面/侧面/俯视(front/side/overhead)

背景,纯色/星系/森林(solid color/nebula/forest)

打光,柔光/环境光/环形光/霓虹(soft/ambient/ring light/neon)

颜色调性,鲜活/暗黑/柔和(vibrant/dark/pastel)

需要怎样的艺术风格,比如:3D渲染/电影海报/毕加索(3D render/movie poster/Picasso)

观察者镜头选择,比如:微距/长焦(macro/telephoto)

如何组织语言:

把想画的内容和形式用只言片语一条一条列出来,而不是企图用一条完整通顺的话来描述

只言片语的顺序很重要,越想强调的越放到前面

提示语涉及哪些修饰形容角度:

摄影(视角/主题类型/相机类型/镜头类型/用光)

艺术(表现形式/媒体形式)

艺术家(人像/景观/恐怖/二次元/科幻/游戏概念)

插画(3D/各类风格/角色设计)

情绪(各种正面的/各种负面的)

审美特点(活力感/暗黑系/历史感)

以上各角度可以混合使用

提示语还涉及哪些特殊词组:

HDR, UHD, 64K

highly detailed

studio lighting

professional

trending on artstation

unreal engine

vivid colors

bokeh

high resolution scan

sketch/painting

stable diffusion 重点参数解析:

CFG(classifier free guidance),数字越大越贴近提示语的描述

step count,合适为佳,并非越大越好,需要测试

seed,初始随机噪声值,设定同一seed,可以复原已出图片;注意某些seed值与特定提示语配合很好,更容易出效果

如何优化提示语权重

使用 ( ) 增强模型对特定词语的关注,使用 [ ] 减弱其关注

多以使用多个 () 或 [],比如:((( )))、[[ ]] 等

也可以使用 (word:1.5)、(word:0.25) 的方式增强或减弱某个词语的权重

如何混合两个提示词

提示编辑允许您开始对一张图片进行采样,但在中间切换到其他图片。其基本语法为 [from:to:when]

比如:a [fantasy:cyberpunk:16] landscape,16步之前是 a fantasy landscape,16步之后是 a cyberpunk landscape

比如:a [mountain:lake:0.25],假定sampler有100步,则前25步是 a mountain,后75步是 a lake

补充信息

提示语长度,旧版的 stable diffusion 有效token长度只有75,简单理解,只能支持70个左右的单词数量,新版的移除了token长度限制,但总体而言,不宜用特别长的提示语