阿里巴巴在百度、腾讯之后也加入AI大军,阿里AI将以星际争霸作为测试场景,让AI参与协同作战,在多人作战中打败对手,目前研究难度比较大,相比围棋AI数据参数更加复杂。

过去十年中,人工智能取得了长足的进步,在图像和语音识别上已经在某种程度上超越了人类。而通过反馈奖励,单个的AI智能体也能在雅达利这样的视频游戏和围棋中战胜人类。

但人类真正的智能还包括了社会和集体智能,这也是实现通用智能必不可少的。就像虽然单个蚂蚁的智能有限,但通过协作它们能狩猎,能筑巢,能发动战争。毫无疑问,人工智能的下一个挑战就是让大规模的AI智能体学习人类水平的协作与竞争。

协作的一个例子就是星际这样的即时战略游戏。最近阿里巴巴与伦敦大学的研究人员们,就在一篇论文中展示了如何用星际争霸作为测试场景,让智能体协同工作,在多对一和多对多中打败敌人。

掩护攻击

这项研究主要关注星际中的微管理任务,每个玩家控制自己的单位,在不同的地形条件下歼灭对手。星际这样的游戏对计算机来说可能是最困难的,因为它们的复杂程度比围棋要高得多。这种大型多智能体系统学习面临的主要挑战是,参数空间会随着参与人数的增加而呈指数级增长。

研究人员让多智能体把星际中的战斗当作零和随机游戏来学习。为了形成可扩展且有效的通讯协议,研究者引入了一个多智能体双向协调网络BiCNet,智能体可以通过它来交流。另外,研究中还引入了动态分组和参数共享的概念,来解决扩展性问题。

边打边跑策略

BiCNet可以处理不同地形下的不同类型的战斗,且对战时双方都有不同数量的AI智能体。

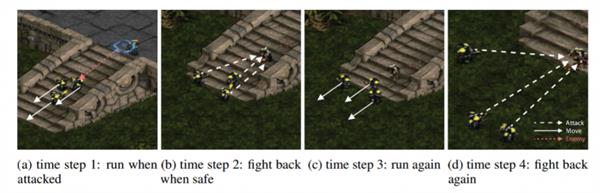

分析显示,在没有任何诸如人类示范或标签数据的监督时,BiCNet也能学习各类协调策略,而这些策略与经验丰富的玩家所展现出来的很相似,比如在不引发冲突的情况下移动,边打边跑等基本策略,以及 掩护攻击与适度集中火力等高级技巧。

另外,BiCNet还可以轻易适应异构智能体任务。在实验中,研究者根据不同的场景对网络进行了评估,发现它表现优异,在大规模现实应用中有潜在价值。

研究中还发现,指定的奖励与学习策略之间存在很强的相关性。研究人员计划进一步研究这种关系,研究 策略如何在智能体网络中传递,以及是否会出现特定的语言。另外,双方都通过深度多智能体模型来操作时,纳什均衡的的探讨也很有意义。